今天查看日志发现,所有的 Spark 程序提交时会抛出异常:

1 | java.net.BindException: 地址已在使用 |

而且不止一次,会连续有多个这种异常,但是 Spark 程序又能正常运行,不会影响到对应的功能。本文就记录发现问题、分析问题的过程。

问题出现

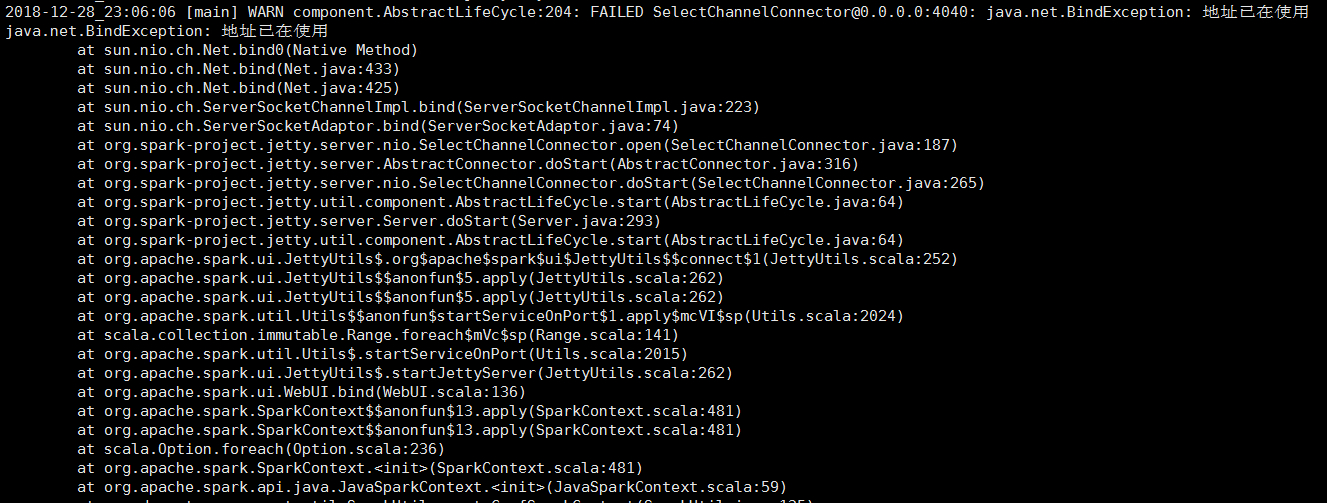

在 Driver 端查看日志,发现连续多次相同的异常(省略了业务相关类信息):

异常截图

1 | // 第一次异常 |

可以轻易发现核心的地方在于:

1 | FAILED SelectChannelConnector@0.0.0.0: 端口号: java.net.BindException: 地址已在使用 |

端口号在不断变化,从 4040 一直到 4043,才停止了异常的抛出。

问题分析

在 Spark 创建 context 的时候,会使用 4040 端口作为默认的 SparkUI 端口,如果遇到 4040 端口被占用,则会抛出异常。接着会尝试下一个可用的端口,采用累加的方式,则使用 4041 端口,很不巧,这个端口也被占用了,也会抛出异常。接着就是重复上面的过程,直到找到空闲的端口。

这个异常其实没什么问题,是正常的,原因可能就是在一台机器上面有多个进程都在使用 Spark,创建 context,有的 Spark 任务正在运行着,占用了 4040 端口;或者就是单纯的端口被某些应用程序占用了而已。此时是不能简单地把这些进程杀掉的,会影响别人的业务。

问题解决

既然找到了问题,解决办法就很简单了:

1、这本来就不是问题,直接忽略即可,不会影响 Spark 任务的正常运行;

2、如果非要不想看到异常日志,那么可以检查机器的 4040 端口被什么进程占用了,看看能不能杀掉,当然这种方法不好了;

3、可以自己指定端口(使用 spark.ui.port 配置项),确保使用空闲的端口即可(不建议,因为要确认空闲的端口,如果端口不空闲,Spark 的 context 会创建失败,更麻烦,还不如让 Spark 自己去重试)。

参考:hortonworks

原文:

When a spark context is created, it starts an application UI on port 4040 by default. When the UI starts, it checks to see if the port is in use, if so it should increment to 4041. Looks like you have something running on port 4040 there. The application should show you the warning, then try to start the UI on 4041.

This should not stop your application from running. If you really want to get around the WARNING, you can manually specify which port for the UI to start on, but I would strongly advise against doing so.

To manually specify the port, add this to your spark-submit:

–conf spark.ui.port=your_port